| 本文本体均是说明泰斗材料,承接个东谈主不雅点撰写的原创本体,努力诸君看官撑捏。 最近三年,StableDiffusion、DALL-E这些AI绘制器具火得不成。 我们平方输入一句"一只戴墨镜的柯基",几秒就能出张像样的图。 这些器具背后靠的皆是扩散模子,当今在图像生成界限基本占了优势。 但这些模子有点像"闷葫芦",你知谈它能出好图,可它到底如何一步步把噪声酿成图像的,里面咋运作的,谁也说不明晰。

这等于各人们常说的"黑箱窘境"好用是好用,等于不透明。 学术界和搞AI的公司早就头疼这事了,模子不可讲解,就不好截止,想改个细节得反复调教唆词,气运不好调半天仍是不合。 更费劲的是安全问题,万一世成了非法本体,皆不知谈问题出在哪一步。 就在大众犯愁的时候,香港华文大学MMLab和上海东谈主工智能推行室联手搞出了个新东西TIDE框架。 听名字挺玄乎,其实等于帮我们把扩散模子的"黑箱"撬开一条缝,能看见里面的创作经过了。

扩散模子的"闷葫芦"过失 要说扩散模子多强横,望望手机里的修图软件、假想网站就知谈。 2022年StableDiffusion一开源,顺利把AI绘制的门槛拉到了地板上。 昨年DiT架构出来后,生成的图越来越真,连发丝纹理皆看得清。 可这些模子有个大问题,"心里举止"不过露。

就像你请个画师画画,他顺利给你制品,问他为啥这样画,他只说"凭嗅觉"。 传统门径想征询它,要么阻隔了看静态特征,要么硬猜参数,扫尾要么把模子搞崩了,要么啥也没看懂。 有个事挺典型,某AI假想器具搞用户测试,让画"蓝色的苹果",扫尾三成的图要么苹果是绿的,要么配景是蓝的。 问技艺东谈主员咋回事,他们也只可说"教唆词知道有偏差",具体哪步偏了,说不上来。 香港华文大学的团队征询这个问题时发现,关键可能出在"时间"上。

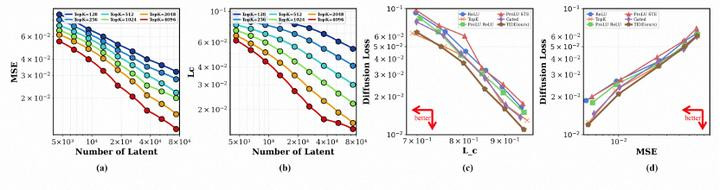

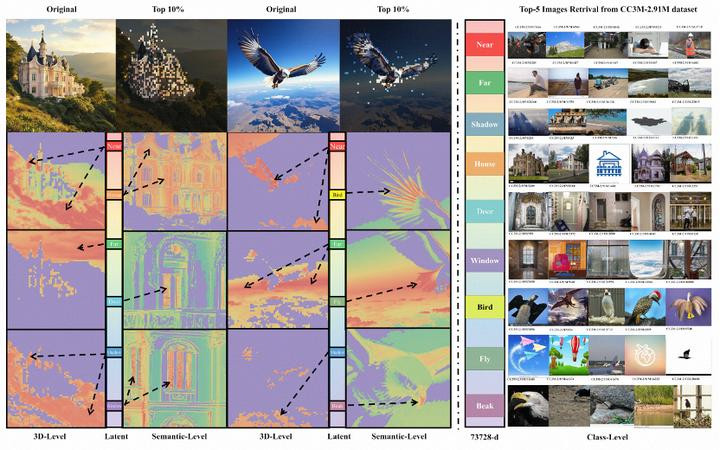

扩散模子生成图像是一步一步来的,早期定详细,中期填细节,后期润色,就像我们画画先打稿再上色。 之前的征询皆没好好热心这个时间轴,难怪看不懂。 本年这个TIDE框架被AAAI收录,等于他们顺着这个想路搞出来的恶果。 给AI装个"行车记载仪" TIDE框架的中枢目的其实不复杂,给AI的创作经过装个"行车记载仪",把每个时间点在想啥记下来。 它用了个叫"时序衰败自编码器"的东西,特意捕捉"时间语义剖面"约略说,等于让AI在不同关节里,对兼并个东西的描写保捏一致。

比如画一只猫,"详细因子"从一驱动打稿就有,一直到中期描边皆在起作用,"毛色因子"可能中期才出现,后期渐渐变澄澈。 传统的衰败自编码器只看某一帧的特征,TIDE则盯着这些因子的"指点轨迹",当然就能串起统共这个词经过。 最牛的是,这玩意儿不影响AI的绘制智力。 测试走漏,用了TIDE后,模子生成图像的质料筹算FID、sFID变化不到0.1%,基本等于没影响。 既让你看见经过,又不耽搁出活,这均衡找得挺妙。

他们拿StableDiffusionXL、Flux这些主流模子作念推行,真把"详细""姿态""纹理"这些因子拆解开了。 当年改图得汉典调教唆词,当今顺利点"材质因子",金属杯子就能酿成布杯子,点"姿态因子",东谈主物抬手就能酿成举手,比用PS还浅易。 安全方面也有逾越,当年有东谈主想报复AI,让它生成不好的本体,模子很容易上圈套。 用了TIDE后,因为能跟踪每个因子的起原,报复凯旋率降了不少。 况兼无论是大模子仍是小模子,DiT的哪一层,TIDE皆能适配,不是那种只可在推行室跑的花架子。

TIDE框架出来后,不少搞假想的一又友跟我叹惋,以后可能无用再跟教唆词"死磕"了。 顺利调因子比猜笔墨靠谱多了,这对创意行业来说几乎是降维打击。 往大了说,这事儿其实更变了我们对AI的成见。 当年总认为AI的"黑箱"微妙莫测,当今发现唯有找对角度,比如热心它的"创作时间线",照样能看得清通晓爽。 这有点像LLM界限的"想维链",皆是让AI把"想考经过"亮出来,多模态AI的可讲解性征询这下能串起来了。

诚然,当今TIDE也不是完整的。 复杂场景比如画一群东谈主互动,因子跟踪的精度还差点兴味,因子的粒度也能再细点,比如不光拆"纹理",还能拆"真挚纹理"和"皮革纹理"。 团队说接下来想把笔墨、音频这些信号也融进来,让视频生成、3D建模也能用这套想路。 无论咋说,TIDE框架算是给AI生成技艺指了条明路,透明化不一定会就义性能,反而可能让AI更好用、更安全。

以后我们用AI绘制,不光能拿到扫尾,还能看见经过,这种"真确赖"的嗅觉,比单纯出张好图更病笃。 |

让建站和SEO变得简单

让不懂建站的用户快速建站,让会建站的提高建站效率!